安装TensorRT-Ubuntu

PyTorch版的YOLOv8是先进的高性能实时目标检测方法。 TensorRT是针对英伟达GPU的加速工具。

ONNX (Open Neural Network Exchange) 作为一个开放的网络模型中间表示(IR)格式,提供了跨框架兼容性。

可以方便不同的框架轻松地交换模型,有助于框架之间的互操作性。

本课程讲述如何对YOLOv8目标检测的PyTorch权重文件转成ONNX格式并进行TensorRT加速部署。

相比与直接使用TensorRT API构建推理引擎,本方法更具灵活性,可用于YOLOv8网络架构修改后的模型部署。

课程亮点包括:

- YOLOv8目标检测的PyTorch权重文件转成ONNX格式,再转成TensorRT 推理引擎

- 支持在GPU上端到端TensorRT加速部署,包括预处理(图像resize, 归一化)、网络推理、后处理(非极大抑制) 均在GPU上执行

- 支持FP16加速

- 提供C++和Python的TensorRT加速命令接口

- 分别在Windows和Ubuntu系统上做YOLOv8的ONNX转换及TensorRT部署演示

- 支持图片、图片文件夹、视频文件的TensorRT的加速推理

- 提供YOLOv8的ONNX转换及TensorRT加速部署代码和代码解析文档

- 实测推理速度提高2倍以上。

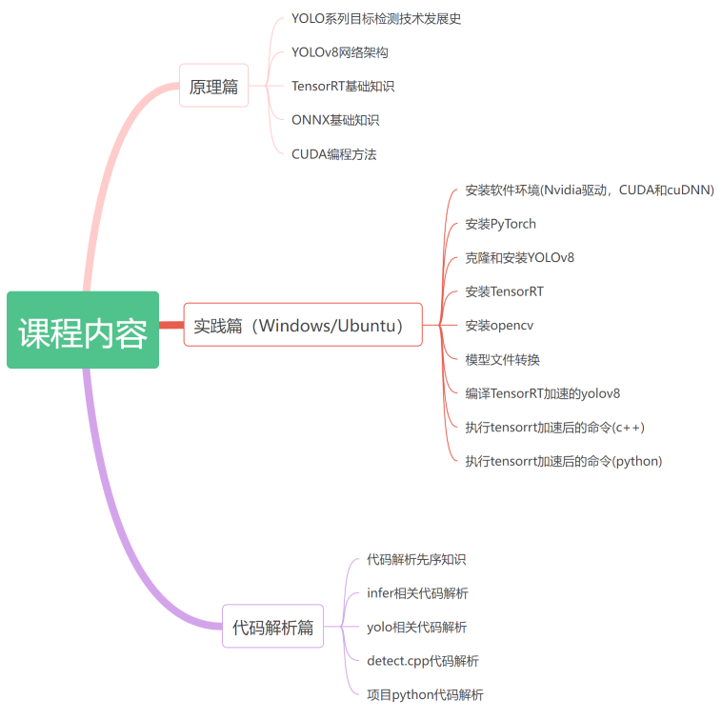

课程内容包括:

- 原理篇(YOLOv8网络架构与组件、TensorRT基础、ONNX基础、CUDA编程方法)

- 实践篇(Windows和Ubuntu系统上的ONNX模型转换及TensorRT加速部署流程演示)

- 代码解析篇(YOLOv8的ONNX模型转换及TensorRT加速的代码解析)

公开笔记对他人可见,有机会被管理员评为“优质笔记”

{{ noteEditor.content.length }}/2000

讲师收到你的提问会尽快为你解答。若选择公开提问,可以获得更多学员的帮助。

课程大纲

75课时

75课时 23课时

23课时 42课时

42课时 40课时

40课时 39课时

39课时 24课时

24课时 31课时

31课时 34课时

34课时