知识蒸馏具体修改代码的讲解

{{ interaction.likeNum == 0 ? (pageType === 'video' ? '抢首赞' : '点赞') : formatNumber(interaction.likeNum) }}

{{ interaction.collectionNum == 0 ? '收藏' : formatNumber(interaction.collectionNum) }}

{{ interaction.discussNum == 0 ? (pageType === 'video' ? '抢沙发' : '讨论') : formatNumber(interaction.discussNum) }}

分享

适合人群

希望学习YOLOv5知识蒸馏和项目实战的学员

你将会学到

学习知识蒸馏的原理和方法;掌握YOLOv5知识蒸馏方法和进行项目实战

课程简介

PyTorch版的YOLOv5是一个当前非常流行的目标检测器,本课程对YOLOv5进行知识蒸馏,来提升其性能。

知识蒸馏(Knowledge Distillation)是模型压缩的一种常用的方法。它利用性能更好的大模型的监督信息,来训练一个轻量化小模型,使小模型达到更好的性能和精度。 最早是由Hinton首次提出并应用在分类任务上,这个大模型称之为教师模型,小模型称之为学生模型。来自教师模型输出的监督信息称之为Knowledge(知识),而学生网络学习迁移来自教师网络的监督信息的过程称之为Distillation(蒸馏)。

本课程在YOLOv5 v6.1版本代码的基础上增加知识蒸馏方法,并实际演示针对自己的数据集训练和进行知识蒸馏过程,并讲解原代码针对知识蒸馏的修改部分。

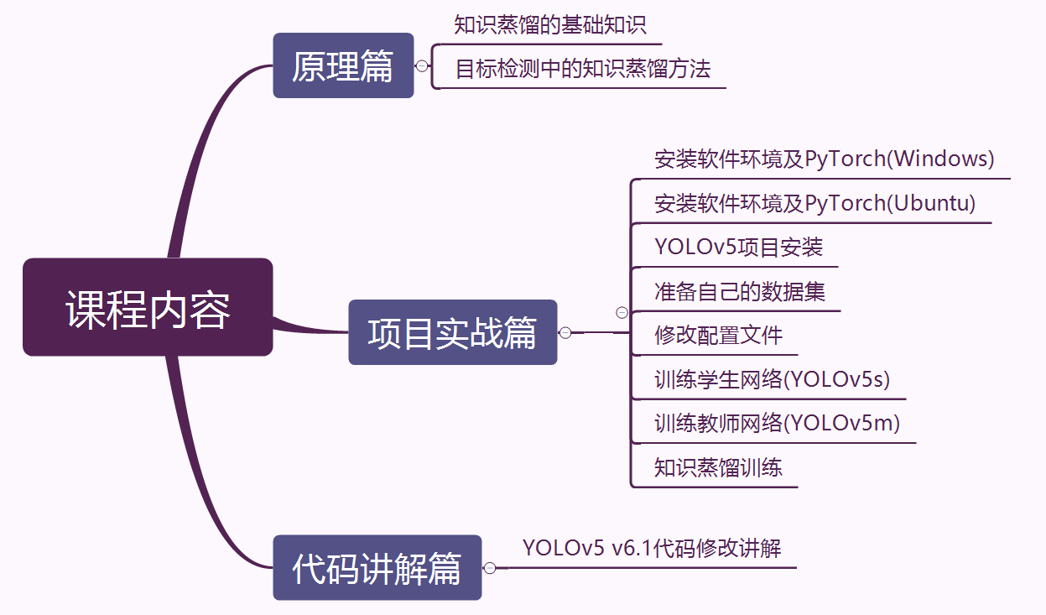

本课程分为原理篇、实战篇、代码讲解篇。

- 原理篇包括:知识蒸馏的基础知识、目标检测中知识蒸馏的方法。

- 实战篇包括:PyTorch环境安装、YOLOv5项目安装、准备自己的数据集、修改配置文件、训练学生网络(Yolov5s)、训练教师网络(训练YOLOv5m)、知识蒸馏训练。

- 代码讲解篇包括:知识蒸馏具体修改YOLOv5 v6.1版本代码的讲解。

展开更多

{{tips.text}}

{{ noteHeaderTitle }}

笔记{{ hasMyNote ? '我的笔记' : '记笔记' }}

{{ hasMyNote ? '我的笔记' : '记笔记' }}

优质笔记

更新于:{{ $dayjs.formate('YYYY-MM-DD HH:mm:ss', item.last_uptime*1000) }}

公开笔记对他人可见,有机会被管理员评为“优质笔记”

{{ noteEditor.content.length }}/2000

公开笔记

保存提问

讲师收到你的提问会尽快为你解答。若选择公开提问,可以获得更多学员的帮助。

记录时间点

记录提问时视频播放的时间点,便于后续查看

公开提问

提交课程大纲

自动连播

75课时

75课时基于深度学习的计算机视觉: 原理与实践 (上部)

55154人学习

白老师

4.9

¥188.00

23课时

23课时YOLOv3目标检测实战:训练自己的数据集

31578人学习

白老师

4.8

¥58.00

42课时

42课时YOLOv5+DeepSORT多目标跟踪与计数精讲

21044人学习

白老师

5.0

¥98.00

40课时

40课时YOLOv5(PyTorch)目标检测:原理与源码解析

19005人学习

白老师

5.0

¥88.00

39课时

39课时YOLOv3目标检测:原理与源码解析

16399人学习

白老师

4.9

¥78.00

24课时

24课时Mask R-CNN图像实例分割实战:训练自己的数据集

15606人学习

白老师

5.0

¥88.00

31课时

31课时YOLOv5实战中国交通标志识别

11637人学习

白老师

5.0

¥88.00

24课时

24课时PyTorch版Mask R-CNN图像实例分割实战:训练自己的数据集(Detectron2)

9723人学习

白老师

5.0

¥88.00